Почему поиск информации вручную больше не работает?

Простых поисковиков и умных чатов уже недостаточно

Самый привычный для нас способ найти нужную информацию – классические «поисковики» (Google, Yandex и др.). В ответ на запрос пользователя они выдают перечень ссылок на страницы, где потенциально может найтись релевантная запросу пользователя информация. Принцип работы – индексация находящегося в сети контента. Однако такой подход не полностью соответствует современным ожиданиям получать максимально точный ответ в кратчайшее время, ведь перед тем как попасть в точку, приходится вручную обрабатывать десяток страниц, содержание которых дублируется или даже искажается из-за рекламного контента. Особенно остро эта проблема ощущается при выполнении профессиональных и исследовательских задач.

В последние годы альтернативой стали умные ассистенты, с помощью которых мы в режиме диалога за считанные секунды мы получаем не просто разрозненный набор ссылок (как при обычном поиске), а готовую формулировку ответа. Однако зачастую даже в этом случае требуется дополнительная проверка, особенно в части фактологии.

Как получить мини-исследование с помощью нейросетевой модели

Мировые гиганты, такие как OpenAI, Microsoft и DeepSeek, борются за возможность сделать свои продукты максимально мощными и экономичными. Вместе с тем большие языковые модели или LLM (те, что «под капотом» у инструментов ИИ-генерации) имеют и определенные ограничения. Одно из самых обсуждаемых – «необъяснимость» и невозможность проверить достоверность полученной информации. Один из способов преодолеть это ограничение – нейросетевые модели RAG (Retrieval-Augmented Generation).

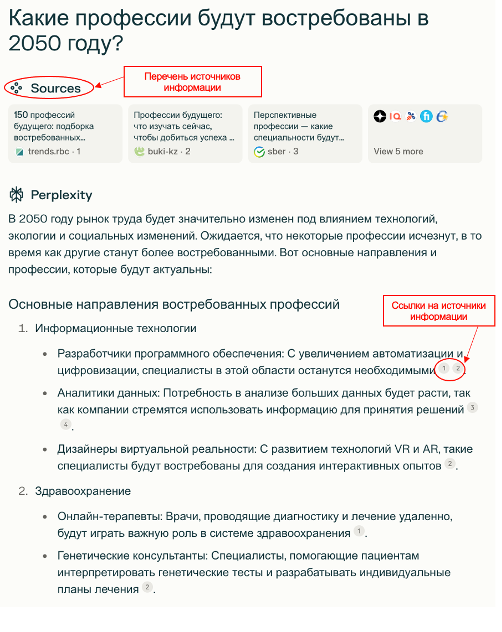

RAG совмещает преимущества инструментов генерации и поисковых систем. Механизм работы включает два основных шага: 1) извлечение информации (Retrieval) и 2) генерация ответа (Generation). То есть, получив запрос от пользователя, система на базе RAG сначала ищет релевантные документы и фрагменты текста в базе знаний либо в интернете, а затем генерирует осмысленный ответ, опираясь на найденную информацию. И что самое важное – каждый тезис в полученном ответе подтверждается ссылкой на источник данных. Это минимизирует вероятность галлюцинаций (создания выдуманных фактов).

Сравним три разных подхода к представлению информации в ответ на запрос «Какие профессии будут востребованы в 2050 году?». Первый вариант – традиционная поисковая система (на примере Яндекс), второй – генерация на базе ChatGPT и третий – RAG-модель сервиса Perplexity. Ключевое отличие последнего сразу бросается в глаза: здесь мы получили текст, напоминающий мини-исследование с ссылками, которые подтверждают его достоверность.

За человеком — осмысление результатов и принятие решения

Появление RAG-моделей расширило и трансформировало понимание возможностей поиска в интернете. Преимущества этой архитектуры стимулируют изменения и в альтернативных подходах к обработке информации. Ее элементы уже внедряются и в поисковых системах (например, функция «поиск с нейро» в Яндексе), и в генеративных чатах (например, опция «искать в сети» в GPT-4o). Постепенно все три метода поиска и подачи информации начинают сближаться.

RAG становится незаменимым помощником для умного и гибкого поиска в большом массиве данных. Базой для него может стать как все информационное пространство интернета, так и узкоспециализированная подборка документов, например юридических или медицинских. По этому принципу, к примеру, работает ИИ-ассистент исследователя на базе iFORA. Используя тщательно отобранную «эталонную» базу источников, он позволяет быстро находить и анализировать актуальные тренды.

Помогая ориентироваться в обилии окружающей нас информации, ИИ создает прочную основу для анализа и принятия решений и служит незаменимым помощником аналитика.

Оригинал статьи доступен по ссылке.

Центр стратегической аналитики и больших данных: Главный эксперт

Все новости автора